그림 인공지능인 Stable Diffusion은 오픈소스이니 만큼 아주 다양한 방법으로 사용할 수 있습니다. 나무위키 사이트에 보면 Stable Diffusion web UI, Text-toArt Discord 등 여러가지 프로젝트가 있다고 하고, NovelAI와 같이 아예 Stable Diffusion 을 기반으로 만들어진 사이트들도 존재합니다.

저는 처음에 Stable Diffusion web UI를 설치하려고 했습니다. 그러다가 클라우드를 통해 스테이블 디퓨전을 사용하는 Google Colab 쪽도 기웃거렸고요. 제가 사용하는 PC가 벌써 몇년쯤 되다 보고(찾아보니 19년 9월이네요) 그다지 고사양이 아니다 보니, 아무래도 로컬로 돌리기는 힘들다 싶었기 때문입니다. 그런데 한번에 설치가 안되고, 여러군데 기웃거리다보니 어디가 어떻게 잘못된지 모를만큼 꼬여버려서 python을 여러번 지우고 설치하고 했는데도 결국 설치하는데 실패하고 말았습니다.

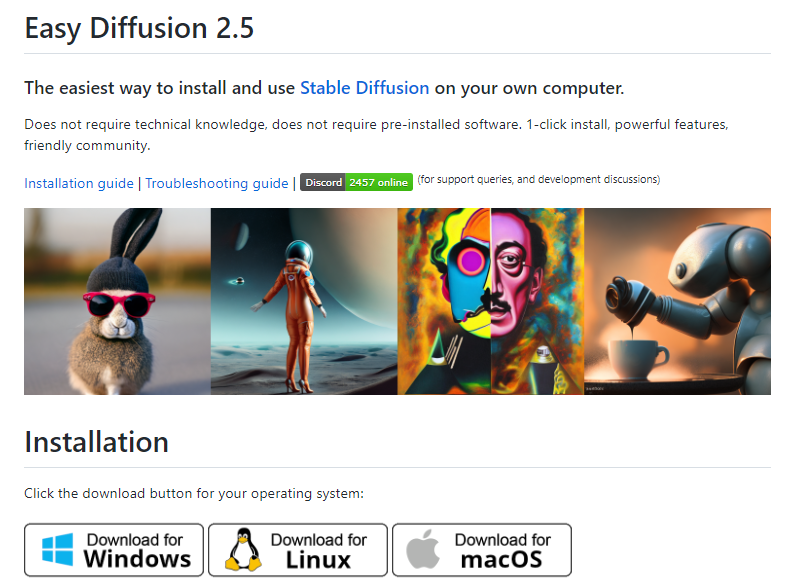

그러다가 Easy Diffusion을 발견했습니다. 오리지널 Stable Diffusion에 여러 편리한 UI를 입힌 방계라고 보면 됩니다. 아래 쓰여진 것처럼, 아무런 기술적 지식도 필요하지 않고, 미리 다른 소프트웨어를 설치할 필요없이 클릭 한 번으로 설치할 수 있다고 해서 였습니다. 제 그래픽카드가 GeForce GTX1050 Ti 인데 간당간당하게 작동 가능하다는 정보도 일조했고요.

2023년 9월 1일, Easy Diffusion 3.0이 출시되었습니다. 설치방법은 동일하니 이 글은 참고만 하세요.

설치는 간단합니다. [Download for Windows] 버튼을 눌러 "Easy-Diffusion-Windows.exe"라는 파일을 적당한 폴더속에 다운로드 받은 후, 더블크릭하면 자동적으로 압축이 풀리면서 설치됩니다.

실행하는 것도 매우 간단합니다. 설치된 디렉토리(C:\EasyDiffusion 등)에 들어가면 아래와 같은 파일들이 설치되는데, 맨 아래에 있는 Start Stable Diffusio U.cmd를 더블 클릭하기만 하면 됩니다.

그러면 윈도 콘솔이 나타나서 뭔가 마구 실행(및 설치)되고 웹탐색기에 아래와 같은 화면이 뜹니다. 이제 스테이블 디퓨전을 사용하면 됩니다. 정말 간단합니다. 아래는 처음 실행된 상태에서(왼쪽위에 a photograph of an astronaut riding a horse 라는 Prompt(문구)가 보입니다.) 그냥 [Make Image] 버튼을 눌러서 나온 결과입니다.

이제 Prompt 창에 적당한 단어를 입력하면 해당 프롬프트에 맞는 인공지능 생성 이미지를 볼 수 있습니다. 며칠 전 설치해두고 몇번 돌려봤는데, 그래픽 카드가 꼬져서 생성 속도가 느리고 큰 이미지를 만들려면 에러가 발생하며, 가끔 완전 이상해 보이는 그림도 만들어지기는 합니다만, 생각보다 잘나와서 아주 재미있게 사용하고 있습니다. ㅎㅎ

===

아래는 이 사이트에서 말하는 Easy Diffusion의 장점을 정리한 겁니다. 참고하세요.

기능

사용자 경험

- 번거로움 없는 설치 : 기술 지식이 필요하지 않으며 소프트웨어를 사전에 설치할 필요가 않습니다. 다운로드하고 실행하기만 하면 됩니다!

- 깔끔한 UI: 친근하고 단순한 UI를 제공하면서도 강력한 기능을 제공합니다.

- 작업 대기열: 현재 작업이 완료될 때까지 기다리지 않고 대기열에 추가시킬 수 있습니다.

- 지능형 모델 감지: 모델 데이터베이스를 통해 선택한 모델에 사용할 YAML 구성 파일을 자동으로 파악합니다.

- 실시간 미리보기: AI가 그리는 이미지를 실시간으로 확인할 수 있습니다.

- 이미지 수정자(modifier): "사실적", "연필 스케치", "아트스테이션" 등과 같은 수정자 태그 라이브러리가 존재합니다. 다양한 스타일을 빠르게 실험해 보세요.

- 여러 프롬프트 파일: 텍스트 파일을 실행하여 여러 프롬프트를 대기열에 넣을 수 있습니다.

- 생성된 이미지를 디스크에 저장: 생성된 영상을 자동으로 저장할 수 있습니다.

- UI 테마: 원하는 대로 테마를 바꿀 수 있습니다.

- 검색 가능한 모델 드롭다운: 모델을 하위 폴더로 구성하고, UI에서 검색할 수 있습니다.

이미지 생성

- 지원: Text2Img 와 Img2Img 를 지원합니다.

- 19개 샘플러(sampler): ddim, plms, heun, euler, euler_a, dpm2, dpm2_a, lms, dpm_solver_stability, dpmpp_2s_a, dpmpp_2m, dpmpp_sde, dpm_fast, dpm_adaptive, unipc_snr, unipc_tu, unipc_tq, unipc_snr_2, unipc_tu_2 등

- 인페인팅: 이미지에서 갱신할 영역을 지정할 수 있습니다.

- 간단한 그리기 도구: 외부 그리기 프로그램 없이도 기본 이미지를 그릴 수 있습니다.

- 얼굴 보정(GFPGAN)

- 업스케일링(RealESRGAN)

- 루프백: 출력 이미지를, 다음 img2img 작업의 입력 이미지로 사용합니다.

- 네거티브 프롬프트: 생성할 영상에서 제거할 속성을 지정합니다.

- 주의/강조: 프롬프트에서 ()를 사용하면 속성을 강조하고, []를 사용하면 속성을 덜 적용하도록 합니다.

- 가중치 프롬프트: 프롬프트에서 특정 단어에 가중치를 사용하여 중요도를 변경합니다(예: red:2.4 dragon:1.2).

- 프롬프트 매트릭스: a photograph of an astronaut riding a horse | illustration | cinematic lightingn 과 같이, 여러가지 프롬프트 변형을 쉽게 생성할 수 있습니다.

- 1-클릭 업스케일/얼굴 보정: 이미지가 생성된 후 이미지를 업스케일링하거나 보정합니다.

- 비슷한 이미지 만들기: 생성된 이미지의 여러 가지 변형을 생성할 수 있습니다.

- NSFW 설정: 후방주의(NSFW) 콘텐츠 생성 여부를 제어할 수 있습니다.

- JPEG/PNG/WEBP 출력: 여러 파일 형식을 지원합니다.

고급 기능

- 사용자 지정 모델: .ckpt 또는 .safetensors 파일을 models/stable-diffusion 폴더에 넣으면, 다른 모델을 적용할 수 있습니다.

- 스테이블 디퓨전 2.1 지원

- 모델 병합: 여러 모델을 합쳐서 사용할 수 있습니다.

- 사용자 지정 VAE 모델 사용

- 사전 학습된 하이퍼네트워크 사용

- 커스텀 GFPGAN 모델 사용

- UI 플러그인: 커뮤니티에서 생성한 UI 플러그인 목록에서 선택하거나 직접 플러그인을 작성할 수 있습니다.

성능 및 보안

- 빠름: NVIDIA 3060 12GB에서 512x512 이미지(euler_a)를 5초 만에 생성합니다.

- 낮은 메모리 사용량: 3GB 미만의 GPU RAM으로 512x512 이미지를 생성하고, 4GB 미만의 GPU RAM으로 768x768 이미지를 생성할 수 있습니다.

- CPU 사용 가능 : 호환되는 그래픽 카드가 없을 경우에도 실행 가능합니다.

- 멀티 GPU 지원: 사용 가능한 경우, 작업을 여러 GPU에 자동으로 분산하여 더 빠른 성능을 제공합니다!

- 악성 모델 자동 검사: picklescan을 사용하여 악성 모델을 방지합니다.

- 세이프텐서(safetensor) 지원: 세이프텐서 형식의 모델 로딩을 지원하여 안전성을 높입니다.

- 자동 업데이터: 최신 개선 사항 및 버그 수정 사항을 자동으로 반영합니다.

- 개발자 콘솔: Stable Diffusion 코드를 수정하고 콘다 환경을 편집하려는 개발자를 위한 모드를 지원합니다.

====

여러가지 좋은 말이 많이 써있고... 제가 모르는 내용도 많은 데, 공부하면서 계속 업데이트하겠습니다~

민, 푸른하늘