스테이블 디퓨전은 기본적으로 텍스트를 기반으로 이미지를 생성해주는 이미지 생성형 AI입니다. 앞서 몇번의 글에서 언급한 것처럼, 스테이블 디퓨전은 여러 이미지 간의 일관성을 유지하기 힘들었습니다. 지금까지는요. 하지만, 이제는 이미지간의 일관성을 넘어 비디오를 기반으로 새로운 비디오를 생성하는 게 가능해졌다는 내용입니다.

적용된 기술을 간단하게 말씀드리면, 기존 디퓨전 모델에 전체적인 스타일을 유지하는 제약조건, 색상을 유지하는 제약조건, 형태를 유지하는 제약조건, 텍스처를 유지하는 제약조건 등을 모두 통합해서, 비디오의 전체적인 일관성 뿐만 아니라, 국부적 시간적 일관성을 유지하는 데 성공했다는 내용입니다.

아직 소프트웨어는 공개되지 않았지만, 정식 논문 발표와 함께 공개될 예정이라고 하는데, 이 방법론이 이 글에 있는 내용을 그대로 구현한다면, 그야말로 누구나 쉽게, 그러면서도 부드럽고 깔끔해서 전혀 위화감이 느껴지지 않는 인공지능 비디오를 생성할 수 있게 될 것 같네요.

일단 아래 사이트에 들어가면 테스트 해볼 수 있습니다. 다만, 완전한 비디오가 생성되는 건 아니고 키 프레임만 만들 수 있습니다. 그래도 키 프레임간의 일관성이 잘 유지되는 걸 보면, 비디오 품질도 상당히 괜찮을 것으로 예상됩니다.

https://huggingface.co/spaces/Anonymous-sub/Rerender

언젠가는 가능해질 거라고 생각했지만, 이렇게나 빨리... 하는 생각이 드네요 기대가 큰 만큼 두려움도 커집니다.

===

대규모 text-to-image 디퓨전 모델은 고품질 이미지를 생성할 경우, 매우 뛰어난 성과를 보여줍니다. 그러나 이러한 모델을 비디오 영역에 적용할 경우, 비디오 프레임 간에 일관성을 보장하는 것은 여전히 어렵습니다. 이 논문에서는 이미지 모델을 비디오에 적용하기 위한 새로운 제로샷 텍스트 지원 비디오-비디오 변환 프레임워크(zero-shot texrt-guided video-to-video translation framework)를 제안합니다.

이 프레임워크는 키 프레임 변환과 전체 비디오 변환 등 두 부분으로 구성됩니다. 첫 번째 키 프레임 변환 부분에서는 적응형 디퓨전 모델(adaptive diffusion model)을 사용하여 키 프레임(key frame)을 생성하고, 계층적 프레임 간 제약 조건(hierarchical cross-frame constraints)을 적용하여 모양, 질감 및 색상 등의 일관성을 유지합니다.

두 번째 전체 비디오 변환 부분에서는 시간을 인식하는 패치 매칭(temporal-aware patch matching)과 프레임 블렌딩(frame blending)을 통해서, 키 프레임을 인근의 다른 프레임으로 전파시킵니다. 이 프레임워크는 재교육이나 최적화 없이도 저렴한 비용으로 비디오 전체의 스타일과 국부적인 텍스처의 시간적 일관성을 달성합니다.

이 기법은 이미지에 대한 기존 디퓨전 기법과 호환되므로, LoRA를 사용하여 특정 피사체를 커스터마이징하고, ControlNet으로 추가적인 공간 가이드를 도입하는 등의 기존 기법을 활용할 수 있습니다. 광범위한 실험 결과를 통해, 이 프레임워크가 고품질의 시간적 일관성을 갖춘 동영상을 렌더링하는 데 있어 기존 방법보다 효과적임을 입증했습니다.

계층적 프레임간 제약조건(hierarchical cross-frame constraints)

우리는 일관된 비디오 프레임을 생성하기 위해, 사전 학습된 이미지 디퓨전 모델에 적용하는 새로운 계층적 프레임간 제약 조건을 제안합니다. 여기서 핵심 아이디어는 광학적 흐름을 사용하여 조밀한 교차 프레임 제약조건을 적용하는 방법으로서,이전에 렌더링된 프레임은 현재 프레임에 대한 하위 레벨 참조로 사용하고, 첫 번째 렌더링된 프레임은 초기의 형태를 벗어나지 않도록 렌더링 프로세스를 조절하는 앵커 역할을 담당하게 하는 방식입니다.

계층적 프레임간 제약 조건은 디퓨전 샘플링의 여러 단계에서 적용됩니다. 이 방법에서는 글로벌 스타일 일관성(교차 프레임 주의, cross-frame attention) 외에도 초기, 중간, 후기 단계에서 각각 형태(형태 인식 교차 프레임 잠재적 융합, shape-aware cross-frame latent fusion), 텍스처(픽셀 인식 교차 프레임 잠재적 융합, pixel-aware cross-frame latent fusion), 색상(색상 인식 적응적 잠재적 조정, color-aware adaptive latent adjustment)의 일관성을 적용합니다. 이 혁신적이면서도 간단단 수정만으로 전체 비디오의 일관성 및 국부적, 시간적 일관성을 모두 달성합니다.

시간적 일관성 제약조건의 효과

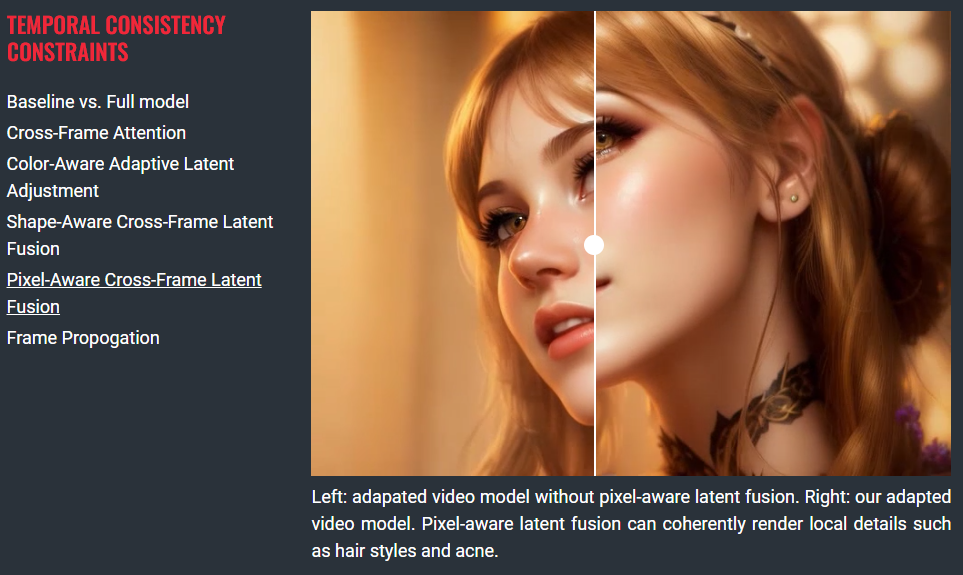

이 프레임워크는 부드러운 결과물을 생성하기 위해 몇 가지 시간적 일관성 제약 조건을 구현합니다. 아래는 기존의 방법론을 적용한 영상(왼쪽)과 이 프레임워크를 모두 적용한 결과물을 비교한 것입니다.

보다 자세한 효과를 비교해 보시려면 원본 글에 들어가 보시기 바랍니다. 중간쯤에 아래와 같은 부분이 있는데, 왼쪽에서 원하는 글을 선택하고, 오른쪽에 마우스를 올리면 구분선을 좌우로 옮길 수 있습니다.

아래는 이 부분에 쓰여진 각각의 제약조건의 효과를 설명하는 내용입니다.

| 교차 프레임 주의(Cross-Frame Attention) | 전체적인 일관성 유지 |

| 색상 인식 적응적 잠재적 조정(Color-Aware Adaptive Latent Adjustment) | 머리카락 색 일관성있게 유지(원본에서는 머리카락 색이 어두워짐) |

| 형태 인식 교차 프레임 잠재적 융합(Shape-Aware Cross-Frame Latent Fusion) | 목걸이 이동같은 국부적인 거친 움직임을 포착할 수 있음 |

| 픽셀 인식 교차 프레임 잠재적 융합(Pixel-Aware Cross-Frame Latent Fusion) | 헤어스타일이나 여드름 같은 국부적인 세부사항을 일관성있게 렌더링 |

| 프레임 전파(Frame Propogation) | 하이브리드 확산 기반 생성 및 패치 기반 전파를 사용하면 보다 부드러운 결과를 생성ㅏ면서도 변환 프로세스를 가속화할 수 있음 |

실험 결과

제로 샷 텍스트 지원 비디오 변환 방법과의 비교

위는 vid2vid-zero, FateZero, Pix2Video, Text2Video-Zero 등 최근에 등장한 네 가지 제로샷 방법과 이 글에서 사용한 기법을 비교한 것입니다. FateZero는 입력 프레임을 성공적으로 재구성하지만 프롬프트와 일치하도록 조정하지 못합니다. vid2vid-zero 및 Pix2Video는 입력 프레임을 과도하게 수정하여 프레임 전체에 걸쳐 심각한 모양 왜곡과 불연속성을 초래합니다. FateZeo의 경우 생성된 각 프레임은 높은 품질을 보여주지만, 로컬 텍스처의 일관성이 부족합니다. 이처럼이 글에서 제안한 방법은 출력 품질, 콘텐츠, 프롬프트 매칭 및 시간적 일관성 측면에서 우월성이 분명합니다.

더 많은 결과

이 글은 https://anonymous-31415926.github.io/의 글을 제가 편하게 수정한 글입니다. 참고하세요.

- Stable Diffusion 인공지능 이미지 생초보 가이드

- Stable Diffusion 대표 UI - AUTOMATIC1111 설치방법

- Automatic1111 GUI: 초보자 가이드(메뉴 해설)

- Stable Diffusion에 대한 기본적인 이론

- ChatGPT로 스테이블 디퓨전 프롬프트 만들기

- Stable Diffusion - 인페인트 가이드

- Stable Diffusion - 모델에 대한 모든 것

- Stable Diffusion - LoRA 모델 사용법

- Stable Diffusion - ControlNet 사용법(1)

- Stable Diffusion - ControlNet 사용법(2)

- Stable Diffusion - 하이퍼네트워크 사용법

- Stable Diffusion - AI 확대도구 사용법

- Stable Diffusion - 구역분할 프롬프트 사용법

- Stable Diffusion으로 멋진 이미지 만들기